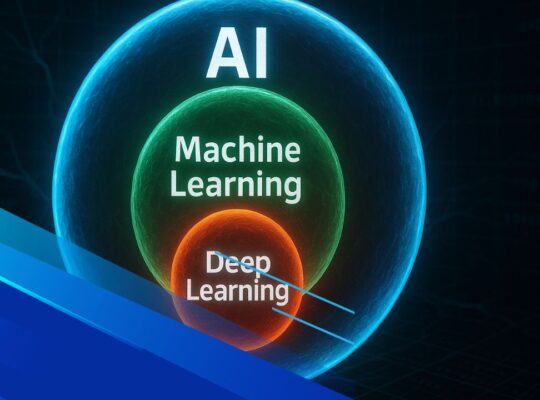

L’AI debole e l’AGI rappresentano due concetti distinti nell’evoluzione dell’intelligenza artificiale: la prima è specializzata in compiti ristretti, la seconda punta a una comprensione e adattabilità paragonabile a quella umana.

Negli ultimi anni, il dibattito su dall’AI debole all’AGI è diventato centrale, poiché i progressi dei modelli generativi e di machine learning ci avvicinano a scenari sempre più avanzati. Comprendere le differenze tra intelligenza artificiale generale e AI ristretta è fondamentale per valutare lo stato attuale e le prospettive future.

Introduzione

Quando si parla di AI debole, ci si riferisce a sistemi progettati per svolgere compiti specifici: dal riconoscimento delle immagini all’assistenza virtuale, fino alla traduzione automatica. Queste applicazioni sono oggi onnipresenti e costituiscono la base dell’attuale ecosistema tecnologico. Diversamente, l’intelligenza artificiale generale mira a replicare la capacità umana di apprendere, ragionare e adattarsi a contesti diversi, superando la logica di un singolo compito predefinito.

L’articolo si propone di rispondere a una domanda chiave: a che punto siamo nel 2025 nel passaggio dall’AI debole all’AGI? Analizzeremo definizioni, differenze, casi d’uso e lo stato della ricerca, per offrire un quadro chiaro e aggiornato. Inoltre, come già visto nei nostri approfondimenti su machine learning e AI generativa, la chiave è osservare come l’evoluzione tecnologica si intrecci con fattori sociali, economici ed etici.

Che cos’è l’AI debole

L’AI debole, o narrow AI, è l’intelligenza artificiale progettata per eseguire compiti specifici con elevata precisione ma senza capacità di adattamento generale.

Si tratta della forma più diffusa di intelligenza artificiale nel 2025: sistemi addestrati su set di dati mirati, capaci di offrire risultati eccellenti in campi come il riconoscimento vocale, l’analisi delle immagini, le raccomandazioni personalizzate e gli assistenti virtuali. Queste applicazioni dimostrano l’enorme potenziale dell’AI debole, ma evidenziano anche i suoi limiti: l’incapacità di ragionare al di fuori del perimetro per cui sono state progettate.

Caratteristiche principali

- Specializzazione in un unico compito o in un set ristretto di attività.

- Dipendenza da grandi quantità di dati etichettati.

- Assenza di autonomia e consapevolezza.

- Impossibilità di trasferire l’apprendimento da un dominio a un altro.

Esempi concreti nel 2025

Oggi incontriamo quotidianamente applicazioni di AI ristretta: dai chatbot per l’assistenza clienti agli algoritmi che filtrano le notizie sui social, fino ai software che supportano la diagnosi medica. Anche i moderni modelli di AI generativa, sebbene avanzati, rientrano nella categoria di AI debole, perché non possiedono un’autentica comprensione del mondo ma generano risposte basate su correlazioni statistiche.

Vantaggi e limiti

Il principale vantaggio dell’AI debole è l’efficienza: consente di risolvere problemi complessi in tempi ridotti, migliorando processi produttivi, customer experience e ricerca scientifica. Tuttavia, i limiti emergono chiaramente quando si tenta di spostare queste capacità su contesti nuovi. La mancanza di generalizzazione e la dipendenza dai dati la distinguono radicalmente dall’AGI, l’orizzonte verso cui la comunità scientifica guarda con crescente attenzione.

Che cosa si intende per AGI

L’AGI, o Intelligenza Artificiale Generale, è un modello teorico di AI capace di apprendere, ragionare e adattarsi a qualsiasi compito cognitivo in maniera simile all’essere umano.

A differenza dell’AI debole, che eccelle solo in ambiti specifici, l’AGI punta a una comprensione universale dei problemi. Ciò significa non solo saper risolvere attività predefinite, ma anche trasferire conoscenze tra domini diversi, adattarsi a contesti nuovi e mostrare forme di ragionamento astratto e creatività.

Capacità attese dell’AGI

- Apprendere concetti generali e applicarli a scenari non previsti.

- Integrare competenze linguistiche, logiche e sensoriali in un unico sistema.

- Svolgere attività che richiedono adattabilità e flessibilità.

- Ragionare in modo indipendente, generando soluzioni originali a problemi complessi.

- Gestire memoria a lungo termine e continuità contestuale.

Modelli teorici e concetti chiave

Nella letteratura scientifica, l’AGI è descritta come una forma di AI forte, in grado di superare i confini dell’AI ristretta. Alcuni studiosi la collegano al concetto di superintelligenza, ovvero un’intelligenza che potrebbe addirittura superare le capacità cognitive umane. Altri, invece, vedono l’AGI come un traguardo intermedio, necessario per costruire sistemi realmente autonomi ma ancora soggetti a limiti etici e normativi.

Concetti come auto-miglioramento, consapevolezza artificiale e allineamento etico sono centrali nelle discussioni contemporanee. Questi temi non riguardano solo la ricerca tecnologica, ma anche il modo in cui la società si prepara a convivere con un’intelligenza artificiale che non sia più solo uno strumento, bensì un vero e proprio interlocutore cognitivo.

Stato del progresso al 2025

Nel 2025 l’intelligenza artificiale ha raggiunto risultati impressionanti, ma l’AGI rimane ancora un obiettivo non realizzato.

I sistemi attuali mostrano capacità notevoli in settori come la generazione di linguaggio, l’analisi predittiva e la visione artificiale. Strumenti basati su modelli di machine learning e deep learning sono ormai adottati in ambito medico, legale, educativo e industriale. Tuttavia, nonostante i progressi, questi sistemi restano esempi di AI debole, in quanto non possiedono la capacità di adattarsi a scenari radicalmente nuovi senza ulteriore addestramento.

Risultati concreti raggiunti

- Algoritmi di linguaggio naturale capaci di interazioni complesse e contestualizzate.

- Applicazioni di AI generativa nella creazione di contenuti, design e ricerca scientifica.

- Modelli multimodali in grado di elaborare testo, immagini e suoni in modo integrato.

- Sistemi predittivi avanzati per mercati finanziari, clima e medicina personalizzata.

Limiti ancora presenti

Nonostante i risultati, gli attuali modelli evidenziano difficoltà importanti: mancanza di consistenza nelle risposte, incapacità di comprendere il significato profondo, dipendenza da grandi quantità di dati e limiti nella memoria a lungo termine. Questi aspetti segnano il confine che separa l’AI odierna da una vera intelligenza artificiale generale.

Previsioni degli esperti

Secondo studiosi e leader del settore, una forma embrionale di AGI potrebbe emergere tra il 2030 e il 2040, anche se le opinioni sono divergenti. Alcuni ritengono possibile lo sviluppo di una proto-AGI già entro il prossimo decennio, capace di superare parzialmente i limiti attuali. Altri, invece, sottolineano come ostacoli tecnici, etici e normativi renderanno inevitabile un percorso più lungo. Ciò che appare certo è che il 2025 segna una fase cruciale: un punto di svolta in cui la transizione da AI debole ad AGI non è più soltanto teoria, ma una sfida concreta in corso.

Le sfide tecniche da superare

Il passaggio dall’AI debole all’AGI richiede di affrontare sfide tecniche, infrastrutturali ed etiche che oggi rappresentano i principali ostacoli allo sviluppo.

Nonostante i progressi, i sistemi attuali restano vincolati a limiti strutturali che impediscono di raggiungere un livello di intelligenza artificiale generale. Per trasformare le capacità dei modelli attuali in una vera forma di autonomia cognitiva, sarà necessario colmare gap significativi su più fronti.

Barriere algoritmiche

- La generalizzazione rimane un problema: i modelli eccellono in contesti addestrati ma falliscono di fronte a scenari imprevisti.

- Il ragionamento logico e astratto è ancora superficiale e spesso incoerente.

- La memoria a lungo termine è limitata: gli algoritmi tendono a dimenticare o a non collegare efficacemente informazioni distanti.

- Manca una vera autonomia decisionale, poiché le azioni sono sempre vincolate ai dati di addestramento.

Limiti infrastrutturali

Un’AGI richiede potenza di calcolo e infrastrutture oggi non ancora sostenibili. I costi energetici, l’accesso a dati bilanciati e l’ottimizzazione degli hardware restano nodi centrali. Senza un’evoluzione significativa in termini di efficienza, la scalabilità dei sistemi sarà difficile da raggiungere.

Questioni etiche e normative

Oltre alle sfide tecniche, emergono problemi di allineamento etico e di sicurezza. Una macchina capace di apprendere in modo autonomo deve rispettare valori condivisi e non minacciare la società. Temi come bias, trasparenza, uso improprio e potenziali rischi esistenziali sono oggi al centro del dibattito internazionale. Inoltre, l’assenza di un quadro normativo uniforme rende complessa la creazione di linee guida globali.

Implicazioni sociali

Lo sviluppo dell’AGI avrà effetti diretti sul mondo del lavoro, sulla distribuzione delle competenze e sulle dinamiche sociali. Prepararsi a questo cambiamento significa integrare piani di formazione, politiche di tutela e una visione a lungo termine capace di bilanciare innovazione e responsabilità.

Chi sta lavorando all’AGI e iniziative principali

Il percorso verso l’AGI è guidato da un ecosistema composto da aziende tecnologiche, centri di ricerca e istituzioni accademiche che investono risorse enormi per raggiungere questo obiettivo.

Il 2025 vede una crescente competizione globale: grandi corporation, startup e governi si contendono la leadership nello sviluppo di sistemi capaci di superare i limiti dell’AI debole e avvicinarsi a una vera intelligenza artificiale generale. Ognuno di questi attori contribuisce con approcci differenti, dal miglioramento degli algoritmi al rafforzamento dell’infrastruttura computazionale, fino alla definizione di linee guida etiche.

Aziende tecnologiche

- OpenAI: prosegue con modelli multimodali e sistemi sempre più orientati alla generalizzazione.

- Google DeepMind: focalizzata su coerenza, trasferimento di apprendimento e progressi nel ragionamento simbolico.

- Anthropic e altre startup: impegnate sull’allineamento e sulla sicurezza, elementi fondamentali per evitare rischi.

- Microsoft e Meta: concentrati su applicazioni industriali, cloud e integrazione su larga scala.

Centri di ricerca e università

Le principali università mondiali – dal MIT a Stanford, passando per Oxford e il Politecnico di Zurigo – contribuiscono con studi teorici e sperimentali. Il loro lavoro è spesso complementare a quello delle aziende, fornendo basi scientifiche e sviluppando modelli innovativi orientati alla generalizzazione.

Progetti internazionali e policy

Oltre ai player tecnologici, diversi governi e organismi sovranazionali hanno avviato iniziative per guidare l’evoluzione dell’AGI. L’Unione Europea, attraverso il quadro normativo dell’AI Act, definisce regole per garantire trasparenza e sicurezza. In parallelo, negli Stati Uniti e in Asia, emergono task force dedicate a creare linee guida comuni e a finanziare ricerca sull’AI forte.

Esempi e metriche

Per valutare i progressi, vengono introdotti benchmark specifici che misurano la capacità dei modelli di ragionare in contesti nuovi, integrare modalità diverse e mantenere coerenza nel tempo. Questi parametri rappresentano il punto di riferimento per comprendere quanto siamo vicini al traguardo dell’AGI.

Scenari futuri possibili

Il futuro dell’AGI non segue un’unica traiettoria: diversi scenari sono ipotizzati dagli esperti, con tempistiche e impatti che variano in base ai progressi tecnologici, alle scelte politiche e alla gestione etica.

Il 2025 rappresenta un punto di snodo: siamo lontani dal traguardo finale, ma i passi avanti rendono plausibili previsioni più concrete. Le prospettive spaziano da scenari ottimistici, in cui l’intelligenza artificiale generale si sviluppa in tempi brevi, a visioni più caute che prevedono un’evoluzione lenta e regolamentata.

Scenario ottimistico

Alcuni ricercatori ritengono che entro il prossimo decennio si possa assistere alla nascita di una proto-AGI, capace di unire competenze trasversali e adattabilità mai viste prima. In questa prospettiva, i progressi hardware e l’allineamento etico procederebbero di pari passo, consentendo l’adozione diffusa senza gravi rischi.

Scenario realistico

Un approccio più moderato indica un periodo compreso tra il 2035 e il 2045 per lo sviluppo di un’AGI funzionante. In questo caso, i progressi sarebbero graduali e accompagnati da regolamentazioni internazionali, con un impatto progressivo su settori come il lavoro, l’istruzione e la sanità.

Scenario pessimistico

Secondo altre voci, la realizzazione di una vera AI forte potrebbe richiedere più tempo del previsto, con il rischio di incontrare ostacoli insormontabili legati a limiti teorici o a problematiche di sicurezza globale. In questo quadro, l’AGI rimarrebbe un traguardo lontano, più speculativo che concreto.

Diversi tipi di AGI

È possibile che non esista una sola forma di AGI. Alcuni parlano di sistemi ibridi, che combinano AI debole con meccanismi di adattamento più avanzati, dando vita a una prima generazione di AGI limitata. Altri ipotizzano un’AGI generalista, in grado di affrontare problemi in qualunque dominio cognitivo, fino a scenari di superintelligenza.

Impatto su società ed economia

Qualunque sia la strada, l’arrivo dell’AGI avrà effetti profondi: trasformazione dei mercati del lavoro, nuove opportunità industriali, ridefinizione dei modelli educativi e nuove sfide etiche. Prepararsi a questi scenari significa sviluppare strategie globali per bilanciare innovazione, inclusione e sostenibilità.

Conclusioni

Il 2025 segna un momento cruciale nel percorso dall’AI debole all’AGI: i progressi sono tangibili, ma la distanza dal traguardo finale resta significativa.

L’AI debole domina ancora lo scenario tecnologico, offrendo strumenti concreti e utili in ogni settore, dalla medicina alla finanza, dall’istruzione al marketing. Tuttavia, le sfide legate alla generalizzazione, al ragionamento autonomo e all’allineamento etico dimostrano che l’intelligenza artificiale generale rimane un obiettivo da conquistare, più che una realtà già consolidata.

Gli esperti concordano su un punto: il futuro dipenderà non solo dalla ricerca algoritmica e dalla potenza di calcolo, ma anche dalla capacità di creare regole condivise, garantire trasparenza e favorire un approccio responsabile. Senza una visione etica e sociale, il passaggio dall’AI ristretta all’AGI rischia di produrre squilibri anziché progresso.

Prepararsi significa investire in formazione, aggiornare i quadri normativi e promuovere un dialogo continuo tra scienza, istituzioni e cittadini. Solo così potremo affrontare con consapevolezza la trasformazione più grande dell’era digitale, trasformando il potenziale dell’AGI in una risorsa realmente a servizio dell’umanità.