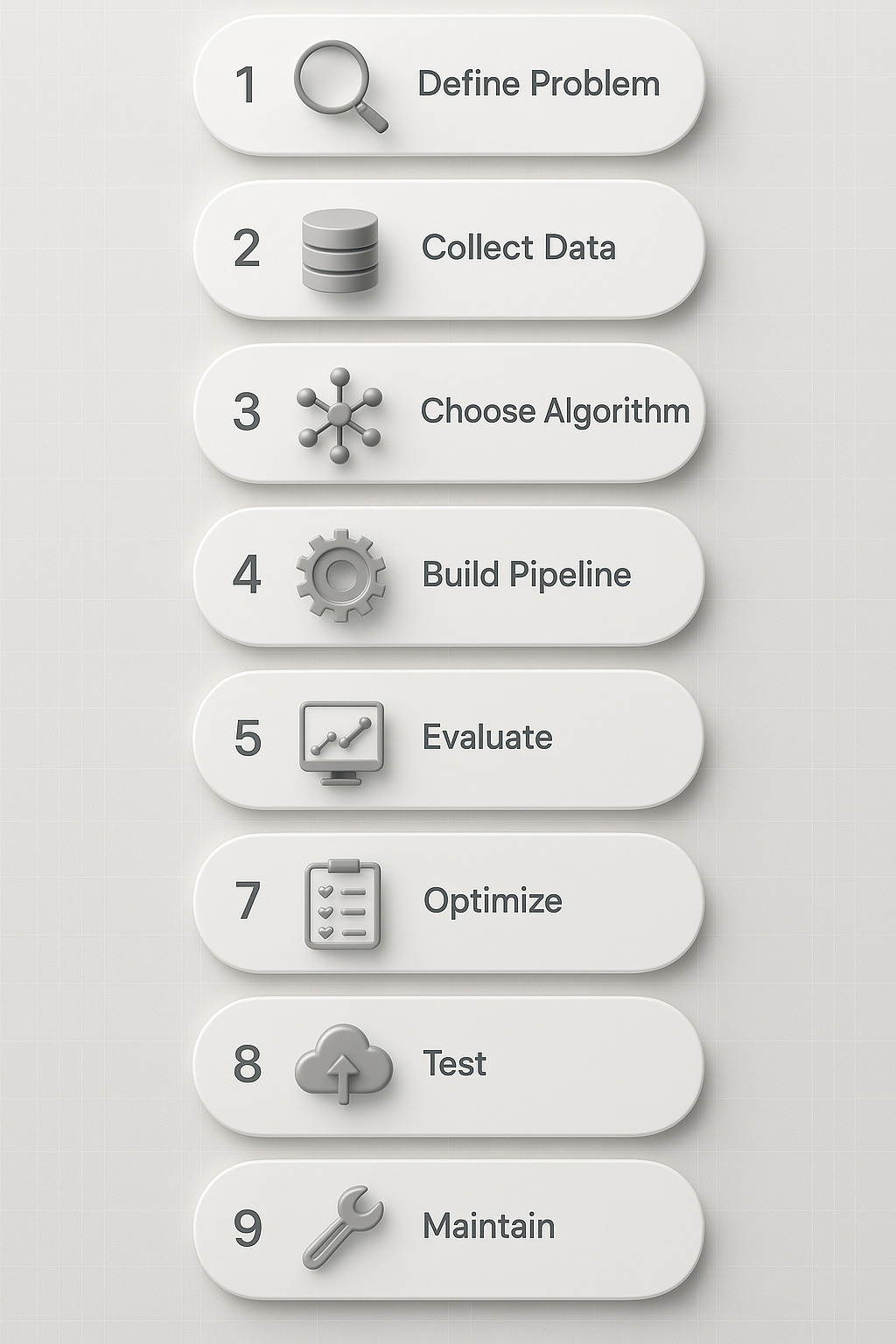

Vuoi imparare come si crea un modello di machine learning da zero, passo dopo passo? Sei nel posto giusto.

Questa guida ti accompagna attraverso le 10 fasi fondamentali per costruire un modello ML efficace, spiegando in modo chiaro e approfondito ogni singolo passaggio: dalla definizione del problema all’ottimizzazione finale, fino al deploy e alla manutenzione continua. Che tu sia un principiante o un professionista che vuole rafforzare il proprio metodo, qui troverai una panoramica completa e concreta, arricchita da esempi pratici, consigli professionali e strumenti pronti all’uso.

Per creare un modello di machine learning è necessario seguire una serie di fasi fondamentali: definizione del problema, raccolta dati, scelta dell’algoritmo, addestramento, valutazione e distribuzione. Ogni passaggio influisce sul risultato finale e sulla capacità predittiva del modello.

Introduzione

Negli ultimi anni, il machine learning è diventato un pilastro della trasformazione digitale in ogni settore: dalla sanità al marketing, dalla finanza all’industria. Ma creare un modello di machine learning efficace non significa solo scrivere codice. È un processo strategico e strutturato, in cui ogni decisione può fare la differenza tra un modello performante e uno inutile.

Questa guida passo passo ti accompagna nella realizzazione di un modello ML, anche se sei alle prime armi o vuoi affinare la tua metodologia. Partiremo dal cuore di ogni progetto: la definizione del problema e degli obiettivi.

1. Definire il problema e gli obiettivi

La prima fase nella creazione di un modello di machine learning è chiarire cosa vuoi risolvere. Senza un problema ben definito, anche il miglior algoritmo fallirà.

🔍 Identifica il tipo di problema

Chiediti: stai cercando di prevedere un valore numerico (problema di regressione), classificare un oggetto in una categoria (classificazione), scoprire pattern nascosti (clustering)? La risposta guida tutto il resto.

Esempi:

- Prevedere le vendite mensili → Regressione

- Riconoscere email spam → Classificazione

- Segmentare clienti in base al comportamento → Clustering

Scegli una metrica di successo

Ogni problema ha una metrica ideale. Eccone alcune:

- Accuratezza o F1-score per classificazione

- RMSE o MAE per regressione

- Silhouette score per clustering

Avere metriche chiare ti permette di valutare in modo oggettivo le performance del tuo modello.

Definisci il contesto e i vincoli

- Quali dati hai a disposizione?

- Hai vincoli di tempo, calcolo, etica o risorse?

- Il modello dovrà girare in real-time, in cloud o embedded?

Ricorda: un buon modello non è solo quello con il punteggio più alto, ma quello che risolve il problema reale nel contesto operativo.

Consiglio da esperto

Prima ancora di aprire un notebook Jupyter o scrivere codice in Python, prendi carta e penna. Disegna una mappa mentale del problema, individua le variabili chiave e chiediti se esistono già soluzioni simili. Un modello ML ben pensato parte dal perché, non dal codice.

2. Raccolta e Preparazione dei Dati: Il Carburante del Modello

I dati sono la base su cui si costruisce ogni modello di machine learning. Senza dati puliti, coerenti e ben strutturati, anche l’algoritmo più sofisticato fallirà.

Una volta definito il problema, è il momento di concentrarsi sulla raccolta e preparazione dei dati, fase spesso sottovalutata ma che incide per oltre il 70% del tempo di sviluppo di un progetto ML.

Dove trovare i dati?

Le fonti variano in base al contesto, ma tra le opzioni più comuni ci sono:

- Dataset pubblici (Kaggle, UCI, OpenML)

- Database aziendali interni

- API esterne

- Sensori IoT o strumenti di tracking

Verifica che i dati siano:

- Rilevanti per il problema

- In formato utilizzabile (CSV, JSON, SQL, ecc.)

- Eticamente e legalmente utilizzabili (rispetto del GDPR, ad esempio)

Data cleaning: pulizia e consistenza

Questa fase consiste nell’individuare ed eliminare:

- Valori nulli o mancanti

- Duplicati

- Outlier anomali

- Errori di formattazione o encoding

Esempio: se stai analizzando prezzi, un valore “-999” non è realistico → andrà trattato.

Utilizza librerie Python come pandas, numpy o openpyxl per automatizzare queste operazioni.

Feature engineering e selezione

Una parte cruciale della preparazione dei dati è trasformare le informazioni grezze in variabili (features) che l’algoritmo possa usare efficacemente.

Esempi:

- Convertire date in “giorno della settimana”, “mese”, “festivo/sì-no”

- Raggruppare categorie rare in una sola voce “Altro”

- Standardizzare valori numerici (scaling, normalizzazione)

Un buon feature set migliora le prestazioni senza dover cambiare modello.

Train-test split e validazione

Suddividi il dataset in:

- Training set (generalmente 70-80%)

- Test set (20-30%)

Questa separazione è vitale per valutare il modello su dati che non ha mai visto prima, evitando l’overfitting.

In alcuni casi, utilizza anche un validation set separato o implementa una validazione incrociata (k-fold) per avere risultati ancora più robusti.

Strumenti utili per questa fase

- scikit-learn → train_test_split, StandardScaler

- pandas-profiling o Sweetviz per analisi esplorativa dei dati

- Missingno per visualizzare dati mancanti

3. Scelta dell’Algoritmo: Il Motore del Tuo Modello di Machine Learning

Scegliere l’algoritmo corretto è essenziale per creare un modello di machine learning efficace, stabile e adatto al problema che si vuole risolvere.

Il tipo di algoritmo influenza le prestazioni, la velocità di addestramento, l’interpretabilità dei risultati e la scalabilità. Non esiste un modello “migliore in assoluto”, ma esiste l’algoritmo più adatto al tipo di dati e obiettivo da raggiungere.

Algoritmi supervisionati

Utilizzati quando hai a disposizione dati etichettati, cioè ogni input è associato a un output atteso.

Per problemi di classificazione:

- Logistic Regression: semplice e veloce, ideale per dati lineari.

- Decision Tree / Random Forest: ottimo per dati complessi e non lineari.

- Support Vector Machine (SVM): preciso, ma più lento su dataset ampi.

- K-Nearest Neighbors (KNN): intuitivo, ma poco efficiente su grandi volumi.

Per problemi di regressione:

- Linear Regression: efficace per relazioni lineari.

- Ridge / Lasso Regression: utile quando serve regolarizzazione.

- Gradient Boosting Regressor: alta accuratezza, gestisce anche outlier.

Algoritmi non supervisionati

Perfetti per individuare pattern in assenza di etichette (output noti).

Esempi comuni:

- K-Means: raggruppa elementi simili (clustering).

- DBSCAN: individua gruppi anche con forme irregolari.

- PCA (Principal Component Analysis): riduce la dimensionalità mantenendo l’informazione.

Algoritmi di deep learning

Se lavori con grandi quantità di dati o strutture complesse (immagini, audio, testo), puoi optare per:

- Reti neurali artificiali (ANN): base del deep learning.

- Convolutional Neural Network (CNN): ideali per il riconoscimento visivo.

- Recurrent Neural Network (RNN): perfette per dati sequenziali (es. serie temporali, testo).

Utilizzano framework come TensorFlow, Keras, PyTorch.

Come scegliere l’algoritmo giusto?

Rispondi a queste 5 domande chiave:

- Qual è il tuo obiettivo? Classificazione, regressione, clustering?

- Che tipo di dati hai? Numerici, categorici, immagini, testo?

- Quanti dati possiedi? Alcuni algoritmi funzionano meglio con dataset ampi.

- Quanto conta l’interpretabilità? Modelli come le decision tree sono facili da spiegare.

- Quali sono i vincoli di tempo o risorse computazionali?

Suggerimento pratico: Inizia con modelli semplici. Se non bastano, passa a modelli più complessi. Spesso, un algoritmo meno sofisticato ma ben configurato dà risultati migliori.

Strumenti per testare e confrontare algoritmi

- scikit-learn: fornisce API uniformi per confrontare facilmente più modelli.

- MLflow o Weights & Biases: per tenere traccia di esperimenti e metriche.

- AutoML tools (es. Google Vertex AI, H2O): testano diversi algoritmi automaticamente.

4. Progettare la Pipeline ML: Automatizzare il Processo di Apprendimento

Una pipeline di machine learning è una sequenza ordinata di passaggi che automatizza il flusso di lavoro, dalla preparazione dei dati fino alla predizione finale, riducendo gli errori e aumentando l’efficienza.

Una volta scelto l’algoritmo, bisogna costruire un processo strutturato e riutilizzabile, in grado di ripetere ogni fase del progetto con coerenza, anche su nuovi dati.

Cos’è una pipeline ML?

Una pipeline è composta da moduli interconnessi che eseguono, in ordine:

- Pre-elaborazione dei dati (pulizia, scaling, encoding)

- Selezione e trasformazione delle feature

- Addestramento del modello

- Valutazione e ottimizzazione

- Predizione su nuovi dati

Questa architettura ti permette di standardizzare il processo e testare rapidamente più modelli o versioni dello stesso algoritmo.

Librerie e strumenti per costruirla

- scikit-learn → Pipeline, ColumnTransformer, GridSearchCV

- TensorFlow Extended (TFX) → flusso completo per deep learning

- Kedro, MLflow, Airflow → gestione pipeline su larga scala

- DVC (Data Version Control) → tracciamento dati e versioni

Esempio base in scikit-learn:

python

CopiaModifica

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression

pipeline = Pipeline([

(‘scaling’, StandardScaler()),

(‘model’, LogisticRegression())

])

Perché usare una pipeline?

- Automazione: ogni volta che arrivano nuovi dati, il processo si esegue senza interventi manuali.

- Riproducibilità: tutto è tracciato e replicabile.

- Manutenibilità: puoi aggiornare una singola parte senza riscrivere tutto.

- Pulizia del codice: separa chiaramente i passaggi e migliora la leggibilità.

Nota importante: la pipeline è anche essenziale in ottica MLOps, dove modelli ML devono essere gestiti in ambienti di produzione come veri e propri software.

Best practice per una pipeline efficace

- Inserisci controlli per la qualità dei dati (range, valori anomali, formati).

- Separa i dati di training, validazione e test in modo chiaro.

- Documenta ogni passaggio per rendere il processo trasparente a team e clienti.

- Usa versionamento dei dati e dei modelli per evitare sorprese in fase di deploy.

5. Addestramento del Modello: Come Insegnare all’Algoritmo a Prevedere

L’addestramento del modello di machine learning è il processo attraverso cui l’algoritmo impara dai dati a fare previsioni accurate, regolando i propri parametri interni per minimizzare l’errore.

È in questa fase che la “macchina” comincia a sviluppare la sua intelligenza. Hai dati preparati, un algoritmo selezionato e una pipeline costruita: ora è il momento di metterli in azione.

Training: cosa accade dietro le quinte

Durante il training, l’algoritmo analizza i dati del training set, cerca schemi e relazioni tra input e output, e aggiorna iterativamente i propri parametri (es. pesi, coefficienti, profondità) per ottimizzare la propria capacità predittiva.

Ogni ciclo di aggiornamento prende il nome di epoca: più epoche, maggiore il grado di apprendimento, ma anche il rischio di overfitting.

Parametri chiave dell’addestramento

- Learning rate: controlla quanto velocemente il modello impara. Un valore troppo alto causa instabilità, uno troppo basso rallenta l’apprendimento.

- Numero di epoche: quante volte il modello vede l’intero dataset.

- Batch size: quante osservazioni vengono analizzate alla volta.

- Loss function: misura l’errore tra la previsione e la realtà (es. MSE, cross-entropy).

Questi iperparametri devono essere scelti con attenzione: influenzano direttamente i risultati finali.

Addestramento supervisionato e non supervisionato

- Nei modelli supervisionati, l’algoritmo confronta le proprie previsioni con le etichette reali e si corregge.

- Nei modelli non supervisionati, cerca autonomamente di individuare strutture nei dati, ad esempio segmentando gruppi con caratteristiche comuni.

Monitoraggio durante il training

Durante l’addestramento, monitora:

- Loss e accuratezza sul training set e sul validation set

- Divergenze tra i due → possibili segnali di overfitting

- Curva di apprendimento → utile per capire quando fermare il training

Visualizza tutto con librerie come matplotlib, seaborn o strumenti più avanzati come TensorBoard e Weights & Biases.

Suggerimenti avanzati

- Applica la Early Stopping per interrompere l’addestramento se non ci sono miglioramenti dopo un certo numero di epoche.

- Normalizza e bilancia i dati per evitare che il modello “favorisca” certe classi.

- Se il dataset è sbilanciato, considera tecniche come SMOTE o pesatura delle classi.

Importante: Non esiste un numero “magico” di epoche o un learning rate perfetto. L’unico modo per trovare la configurazione ottimale è testare, misurare, e ripetere.

Valutazione del Modello: Come Capire se Funziona Davvero

La valutazione di un modello di machine learning serve a misurare quanto bene il modello generalizza su dati mai visti, utilizzando metriche specifiche e strategie di validazione robuste.

Addestrare un modello non basta: è fondamentale capire se le sue previsioni sono affidabili anche al di fuori del dataset su cui ha imparato. Una buona valutazione permette di individuare errori nascosti, bias nei dati o segni precoci di overfitting.

Valutare non è solo “vedere se funziona”

L’obiettivo è quantificare le prestazioni su un insieme di dati separato: il test set. L’analisi deve essere oggettiva, replicabile e basata su indicatori chiari.

Metriche principali per tipo di problema

Per classificazione:

- Accuracy: % di previsioni corrette

- Precision e Recall: ottime per classi sbilanciate

- F1-score: media armonica tra precision e recall

- AUC‑ROC: misura la capacità di distinguere classi

Per regressione:

- Mean Absolute Error (MAE): media degli errori in valore assoluto

- Root Mean Squared Error (RMSE): penalizza maggiormente errori grandi

- R² (coefficiente di determinazione): quanta varianza dei dati è spiegata dal modello

Per clustering:

- Silhouette score: misura la separazione tra i cluster

- Davies-Bouldin index: confronta compattezza e distanza tra gruppi

Tecniche di validazione

Affidarsi a un singolo test può generare risultati distorti. Meglio usare metodi più solidi:

Validazione incrociata (Cross‑Validation)

Divide i dati in k blocchi. Il modello si addestra su k‑1 blocchi e si testa sul rimanente, ripetendo il processo k volte. Risultato: una media delle metriche molto più affidabile.

La più comune è la K‑Fold Cross‑Validation, spesso con k=5 o k=10.

Confusion matrix

Per modelli di classificazione, offre una visione dettagliata delle prestazioni:

- True Positives (TP)

- False Positives (FP)

- True Negatives (TN)

- False Negatives (FN)

Ti permette di rispondere a domande tipo: “Il modello commette più falsi allarmi o omissioni?”

Strumenti utili per la valutazione

- scikit-learn → classification_report(), confusion_matrix(), cross_val_score()

- Yellowbrick → visualizzazione interattiva delle metriche

- TensorBoard (per modelli TensorFlow)

- MLflow per tenere traccia di esperimenti e risultati

Considerazioni finali

Un buon modello non è solo quello che impara, ma quello che generalizza. La valutazione ti dice se hai davvero costruito qualcosa di utile o se hai semplicemente memorizzato dati.

Consiglio da esperto: Non ignorare le metriche secondarie. A volte, un F1-score bilanciato è più importante dell’accuracy, soprattutto in ambiti critici come la medicina o la sicurezza.

6. Ottimizzazione degli Iperparametri: Il Tuning che Fa la Differenza

Ottimizzare gli iperparametri significa trovare la combinazione di valori che massimizza le prestazioni del modello di machine learning, evitando overfitting e migliorando la capacità di generalizzazione.

Anche un buon algoritmo, con dati ben trattati, può dare risultati mediocri se i suoi iperparametri non sono scelti correttamente. È qui che entra in gioco il processo di hyperparameter tuning.

Cosa sono gli iperparametri?

Gli iperparametri sono configurazioni definite prima dell’addestramento, che non vengono apprese dai dati, ma che influenzano profondamente come il modello apprende.

Esempi comuni:

- Learning rate nei modelli neurali

- Profondità massima negli alberi decisionali

- Numero di vicini nel KNN

- Numero di neuroni o layer in una rete neurale

- Parametri di regolarizzazione (es. alpha, lambda)

Ogni algoritmo ha i suoi, e modificarli cambia radicalmente il comportamento del modello.

Tecniche di ottimizzazione degli iperparametri

1. Grid Search

Prova tutte le combinazioni possibili in un intervallo definito. È completo, ma può essere lento se le variabili sono tante.

python

CopiaModifica

from sklearn.model_selection import GridSearchCV

grid = GridSearchCV(model, param_grid, cv=5)

grid.fit(X_train, y_train)

2. Random Search

Sceglie combinazioni casuali tra quelle possibili. È più veloce, ideale per modelli con molti parametri.

3. Bayesian Optimization

Metodo più sofisticato, basato su modelli probabilistici. Sfrutta i risultati precedenti per prevedere quali combinazioni potrebbero funzionare meglio.

Utilizza librerie come Optuna, Hyperopt, Scikit-Optimize.

Cross-validation durante il tuning

Un errore comune è valutare le prestazioni solo su un unico test set. È buona pratica associare le tecniche di tuning a K-fold Cross-Validation per ottenere risultati più stabili e rappresentativi.

Attenzione all’overfitting da tuning

Fare troppi tentativi può portare a un modello troppo “adattato” ai dati del training, perdendo capacità predittiva sul mondo reale. Usa il validation set solo per tuning e il test set una sola volta alla fine.

Consiglio professionale: documenta ogni esperimento, registra le combinazioni testate e conserva i risultati. La tracciabilità è essenziale nei progetti professionali.

Tool utili per il tuning

- scikit-learn → GridSearchCV, RandomizedSearchCV

- Optuna → ottimizzazione bayesiana, veloce e flessibile

- Ray Tune, Keras Tuner → per modelli deep learning complessi

- MLflow, Weights & Biases → per tenere traccia degli esperimenti

7. Test Finale e Analisi delle Prestazioni: Misura, Confronta, Decidi

Il test finale è il momento in cui metti alla prova il tuo modello su dati realmente “nuovi” per verificarne l’efficacia in un contesto vicino alla realtà.

Dopo aver addestrato, validato e ottimizzato il tuo modello, arriva il momento della verità. Il test set serve per simulare l’utilizzo effettivo dell’algoritmo su dati che non ha mai visto, evitando qualsiasi bias introdotto durante le fasi precedenti.

Differenza tra validazione e test

- Validazione: serve per guidare il tuning del modello.

- Test finale: fornisce una valutazione definitiva e imparziale delle sue prestazioni.

Non bisogna mai utilizzare il test set durante l’ottimizzazione: è riservato esclusivamente alla valutazione conclusiva.

Cosa analizzare nel test finale

1. Metriche consolidate

Ripeti le metriche già viste nella validazione (accuracy, F1-score, RMSE, R²…), ma applicale solo sul test set. Confrontale con i risultati ottenuti in fase di validazione: grandi discrepanze potrebbero segnalare overfitting o data leakage.

2. Visualizzazione dei risultati

Usa grafici per comprendere meglio i punti di forza e le debolezze del modello:

- Confusion matrix migliorata

- Curva ROC e AUC

- Grafici residui per modelli di regressione

- Diagrammi di confronto previsione vs realtà

Questi strumenti non solo migliorano l’analisi tecnica, ma facilitano la comunicazione dei risultati anche a stakeholder non tecnici.

3. Analisi per sottogruppi

Verifica che il modello non performi meglio su alcuni gruppi di dati rispetto ad altri (es. utenti di una certa fascia d’età, clienti di una regione geografica, ecc.). È un controllo utile per individuare bias sistemici o modelli troppo “mirati”.

Interpretabilità: capire perché funziona

Un modello performante non basta: serve anche capirlo. Utilizza strumenti di interpretabilità per esplorare:

- Quali feature pesano di più nelle decisioni

- Se il comportamento del modello è coerente

- Se esistono casi limite o anomalie (es. predizioni errate ricorrenti)

Tool consigliati:

- SHAP (SHapley Additive exPlanations)

- LIME (Local Interpretable Model-agnostic Explanations)

- ELI5 per modelli lineari e alberi decisionali

Suggerimento pratico: conserva i modelli migliori in formato serializzato (.pkl, .joblib, .h5) per riutilizzarli o confrontarli in futuro.

Deploy e Monitoraggio: Mettere il Modello in Produzione in Modo Sicuro

Il deploy di un modello di machine learning consiste nel renderlo disponibile per l’uso reale, mentre il monitoraggio serve a garantire che continui a funzionare in modo stabile, preciso e coerente nel tempo.

Hai costruito un modello solido, lo hai testato accuratamente, ma finché non lo porti in produzione, il suo valore rimane potenziale. Il passaggio dal laboratorio al mondo reale richiede attenzione, metodo e strumenti affidabili.

Come avviene il deploy

L’obiettivo è rendere il modello accessibile tramite API, integrato in un’applicazione web, un sistema interno o una pipeline automatica.

Le modalità più comuni sono:

- REST API: espone il modello tramite un endpoint. Esempio: /predict

- Batch processing: il modello elabora periodicamente nuovi dati in blocco

- Edge deployment: il modello viene eseguito su dispositivi locali (es. mobile, IoT)

Framework utili:

- Flask o FastAPI per creare microservizi in Python

- Docker per containerizzare il modello e renderlo portabile

- TensorFlow Serving, TorchServe, MLflow per soluzioni pronte all’uso

Cloud provider come AWS SageMaker, Google Vertex AI, Azure Machine Learning offrono infrastrutture scalabili per il deploy.

Monitoraggio: perché è fondamentale

Il mondo cambia, i dati anche. Un modello che oggi funziona bene potrebbe diventare obsoleto in pochi mesi se non viene controllato.

Cosa monitorare:

- Performance nel tempo (accuracy, errori, tempo di risposta)

- Drift dei dati: variazioni nella distribuzione degli input

- Drift del concetto: cambiamento nel significato della previsione

- Errori imprevisti o richieste fuori dominio

Strumenti di monitoraggio:

- Prometheus + Grafana per metrica e visualizzazione

- Evidently AI per analisi automatica del drift

- Seldon, WhyLabs, Arize AI per MLOps avanzato

Suggerimento professionale: imposta alert automatici in caso di calo nelle prestazioni. Intervenire rapidamente evita danni reputazionali o decisionali.

Sicurezza e compliance

Durante il deploy assicurati che il modello:

- Non esponga dati sensibili

- Rispetti normative come GDPR

- Non presenti bias discriminatori

Auditability, tracciabilità e controllo degli accessi sono aspetti fondamentali in contesti regolamentati (es. sanità, finanza, pubblica amministrazione).

8. Manutenzione e Retraining: Come Garantire un Modello Sempre Aggiornato

8. Manutenzione e Retraining: Come Garantire un Modello Sempre Aggiornato

Un modello di machine learning non è statico: per rimanere efficace nel tempo, deve essere monitorato, aggiornato e, quando necessario, riaddestrato.

Anche i modelli migliori degradano con il tempo. Cambiano i dati, le abitudini degli utenti, le condizioni operative. La manutenzione continua e il retraining periodico sono l’unico modo per garantire affidabilità e performance stabili nel lungo periodo.

Manutenzione: cosa significa in pratica

- Controllo regolare delle performance: confronta le metriche attuali con quelle storiche.

- Verifica del flusso di dati: assicurati che gli input in produzione abbiano lo stesso schema previsto.

- Log degli errori: registra e analizza le anomalie nei risultati.

Questo approccio ti permette di prevenire il degrado piuttosto che reagire a problemi già manifesti.

Quando fare il retraining?

Ci sono segnali chiari che indicano il bisogno di aggiornare il modello:

- Aumento del tasso di errore o calo di accuratezza

- Drift dei dati: i nuovi dati hanno distribuzioni diverse da quelli di training

- Cambio del contesto aziendale: nuove categorie, target diversi, nuovi mercati

- Introduzione di nuove fonti di dati più ricche o rilevanti

Importante: il retraining non è sempre completo. Spesso si parla di incremental learning, cioè aggiornamenti parziali per integrare nuove informazioni senza azzerare la conoscenza acquisita.

Automazione del retraining

Per progetti su larga scala o modelli mission-critical, puoi automatizzare l’intero processo:

- Pianifica retraining mensili o trimestrali

- Utilizza cron job o pipeline CI/CD

- Integra strumenti di versionamento come DVC o MLflow

- Salva e confronta i modelli aggiornati prima di sostituire quello attivo

Framework utili per questo:

- Kubeflow Pipelines

- Amazon SageMaker Pipelines

- Airflow con task ML integrati

Audit e versionamento

Ogni versione del modello dovrebbe essere:

- Tracciata con un ID univoco

- Collegata ai dati, parametri e metriche usati nel training

- Accompagnata da una documentazione tecnica e funzionale

Questo non solo migliora la trasparenza, ma è indispensabile in contesti regolamentati e per progetti enterprise.

In sintesi

Un modello efficace è un modello che evolve. La manutenzione e il retraining sono pratiche essenziali per garantire che le tue soluzioni di machine learning restino al passo con il tempo, i dati e il contesto operativo. Ignorare questa fase significa rischiare di perdere precisione, credibilità e valore.

Conclusioni

Creare un modello di machine learning non è solo questione di codice. È un processo strategico, iterativo e interdisciplinare, che unisce analisi, progettazione, sviluppo e gestione operativa.

Con questa guida hai acquisito una visione strutturata di tutto il ciclo di vita del modello: non solo sai come costruirlo, ma anche come mantenerlo utile nel tempo. Utilizza questa conoscenza per dare forma a progetti solidi, affidabili e orientati all’impatto reale. L’intelligenza artificiale non è solo una tecnologia: è una responsabilità. E ora, è anche nelle tue mani.