Il machine learning ha rivoluzionato numerosi settori, ma presenta ancora limiti importanti che ne frenano l’adozione estesa e la piena affidabilità. Comprendere questi ostacoli è fondamentale per costruire sistemi intelligenti più efficaci, etici e sostenibili.

Limiti tecnici del Machine Learning

Black box: quando i modelli sono opachi

Uno dei principali limiti del machine learning è la sua natura di scatola nera. I modelli complessi, come le reti neurali profonde, raggiungono alte performance ma spesso non permettono di comprendere come arrivano a una determinata decisione. Questa mancanza di trasparenza rappresenta una sfida enorme, soprattutto in settori critici come la medicina, la finanza o la giustizia.

Dipendenza dai dati: quantità non sempre è qualità

I sistemi di apprendimento automatico necessitano di grandi quantità di dati per funzionare. Tuttavia, più dati non significa automaticamente migliori risultati. Se i dati sono sbilanciati, incompleti o contenenti bias impliciti, anche il modello più avanzato potrà produrre risultati distorti o discriminatori.

Consumo computazionale ed energetico

Allenare modelli di deep learning richiede risorse computazionali significative. I costi energetici, l’utilizzo massiccio di GPU e server e le conseguenti emissioni di CO₂ pongono un problema di sostenibilità spesso sottovalutato. Questo limite tecnico si traduce in una barriera concreta all’accesso per molte realtà con risorse limitate.

Generalizzazione limitata e overfitting

Un modello può apprendere bene un set di dati specifico ma fallire completamente su dati nuovi. Questo fenomeno, noto come overfitting, mostra l’incapacità del sistema di generalizzare. È un punto critico quando si lavora in ambienti dinamici o con dataset in evoluzione.

Vulnerabilità agli attacchi adversariali

I modelli di machine learning possono essere facilmente ingannati da piccoli input modificati, chiamati adversarial examples. Questo rende i sistemi poco robusti e suscettibili ad attacchi, con implicazioni gravi soprattutto in ambito cybersecurity e automotive.

In sintesi, le sfide tecniche che accompagnano il machine learning non sono solo ostacoli da superare, ma anche opportunità per riflettere su come rendere questa tecnologia più affidabile, comprensibile e sostenibile nel tempo.

Limiti applicativi del Machine Learning

Nonostante le sue potenzialità, il machine learning mostra evidenti limiti applicativi in contesti reali, dove la complessità del mondo fisico e sociale richiede adattabilità, senso critico e comprensione del contesto.

Modelli che non comprendono il contesto

Uno dei principali problemi riguarda l’incapacità dei modelli di apprendere concetti astratti o interpretare situazioni nuove. A differenza dell’essere umano, un algoritmo non ha una reale comprensione semantica: riconosce pattern nei dati, ma non sa cosa significano davvero. Questo diventa evidente in settori come la robotica o la guida autonoma, dove è richiesta una comprensione dinamica dell’ambiente.

Generalizzazione in ambienti complessi

Il machine learning performa bene in ambienti stabili e controllati, ma mostra limiti quando le variabili aumentano o cambiano rapidamente. In ambiti come la diagnostica medica o la meteorologia, anche un piccolo scostamento dal contesto di addestramento può causare errori significativi.

Affidabilità e sicurezza nei settori critici

Quando applicati a settori ad alto rischio, come il controllo di impianti industriali o la gestione di emergenze, i sistemi intelligenti devono essere estremamente affidabili. Tuttavia, l’assenza di robustezza ai cambiamenti o agli imprevisti rende difficile l’adozione del machine learning in questi contesti senza un forte supporto umano.

Assenza di spiegabilità nelle decisioni operative

Nel mondo reale, ogni scelta deve poter essere giustificata. La difficoltà di spiegare il funzionamento interno dei modelli — in particolare nei sistemi di deep learning — limita la loro applicazione in ambito normativo, legale o manageriale. Questo frena la fiducia degli utenti finali e ostacola l’integrazione di queste soluzioni nei processi decisionali.

Questi limiti applicativi del machine learning rappresentano una sfida concreta per aziende, enti pubblici e ricercatori: per superare la fase sperimentale e diventare strumenti realmente operativi, i modelli devono evolversi in direzione di maggiore adattabilità, trasparenza e affidabilità.

Etica, sostenibilità e impatti sociali dell’Intelligenza Artificiale

I limiti del machine learning non sono solo tecnici o applicativi: coinvolgono anche temi etici, ambientali e sociali che influenzano direttamente la fiducia pubblica e la legittimità dell’uso dell’Intelligenza Artificiale.

Bias algoritmico e discriminazioni

I modelli di apprendimento automatico riflettono i dati con cui vengono addestrati. Se questi contengono pregiudizi impliciti, il sistema può perpetuarli o addirittura amplificarli. Ne derivano discriminazioni nei confronti di genere, etnia o status sociale, specialmente nei settori del recruiting, dei prestiti bancari o della sorveglianza.

Privacy e tracciamento invisibile

L’uso massiccio di dati comporta rischi per la privacy degli utenti. Anche quando i dati sono anonimi, i modelli possono ricostruire informazioni sensibili attraverso correlazioni nascoste. Tecniche emergenti come il federated learning cercano di ridurre questo rischio, decentralizzando l’addestramento e mantenendo i dati sui dispositivi locali.

Impatto ambientale dell’intelligenza artificiale

Allenare modelli complessi richiede una grande quantità di energia. L’addestramento di una singola rete neurale può generare emissioni paragonabili a quelle di diversi voli intercontinentali. La crescente adozione di AI su larga scala impone una riflessione seria sul suo impatto ecologico e sulla necessità di sviluppare modelli più efficienti ed ecocompatibili.

Accessibilità e disuguaglianze globali

Le tecnologie basate su machine learning sono spesso appannaggio di poche grandi aziende e Paesi con risorse. Questo crea un divario crescente tra chi può sviluppare e utilizzare questi strumenti e chi ne rimane escluso. Garantire una diffusione equa dell’innovazione è oggi una delle sfide più rilevanti a livello globale.

Affrontare questi limiti etici e ambientali è cruciale per costruire un’intelligenza artificiale responsabile, che non si limiti a “funzionare bene”, ma rispetti le persone, l’ambiente e le società in cui viene applicata.

Nuove frontiere e soluzioni emergenti nel Machine Learning

Per superare i limiti del machine learning, la ricerca si sta concentrando su nuove metodologie che puntano a rendere i modelli più trasparenti, efficienti e sostenibili, con l’obiettivo di costruire sistemi davvero intelligenti e affidabili.

Machine Learning interpretabile: capire come ragiona l’algoritmo

Una delle direzioni più promettenti è lo sviluppo di modelli ad alta interpretabilità, capaci di spiegare con chiarezza il processo decisionale. Tecniche come le feature importance, le rule-based models o gli XAI (Explainable AI) permettono di verificare su quali elementi si basa una previsione, aumentando la fiducia degli utenti e l’adozione nei contesti regolamentati.

Apprendimento federato: intelligenza distribuita e privacy

Il federated learning consente ai modelli di apprendere direttamente dai dispositivi locali, evitando la centralizzazione dei dati. Questa tecnica emergente garantisce una maggiore privacy e può ridurre anche i costi di trasmissione. È già in uso in ambiti come la sanità e il mobile AI.

Efficienza energetica e modelli più leggeri

Per contrastare l’elevato impatto energetico, i ricercatori stanno sviluppando modelli più snelli e ottimizzati, come le reti neurali sparse o i modelli quantizzati. Questi approcci permettono di ottenere buone performance con meno risorse, rendendo il machine learning più accessibile e green.

Robustezza contro attacchi e imprevisti

L’aumento delle minacce informatiche ha spinto verso la creazione di modelli più robusti, in grado di resistere a dati manipolati (adversarial examples) o condizioni anomale. Tecniche come l’adversarial training e il data augmentation stanno migliorando la sicurezza dei sistemi basati su machine learning.

Integrazione con approcci simbolici e ibridi

Un’altra frontiera è l’unione tra machine learning e intelligenza simbolica. I modelli ibridi cercano di combinare l’apprendimento dai dati con regole logiche, per una comprensione più profonda e una maggiore capacità di ragionamento, avvicinandosi a un’intelligenza più simile a quella umana.

Le nuove frontiere della ricerca nel machine learning non puntano solo a migliorare le performance, ma a rendere questi strumenti più comprensibili, equi e sostenibili. È una trasformazione culturale oltre che tecnologica, che ridisegna il futuro dell’intelligenza artificiale.

Casi pratici e applicazioni reali dei limiti del Machine Learning

I limiti del machine learning non sono solo concetti teorici, ma emergono chiaramente in diversi contesti applicativi, dove la tecnologia viene messa alla prova da complessità, variabilità e responsabilità reali.

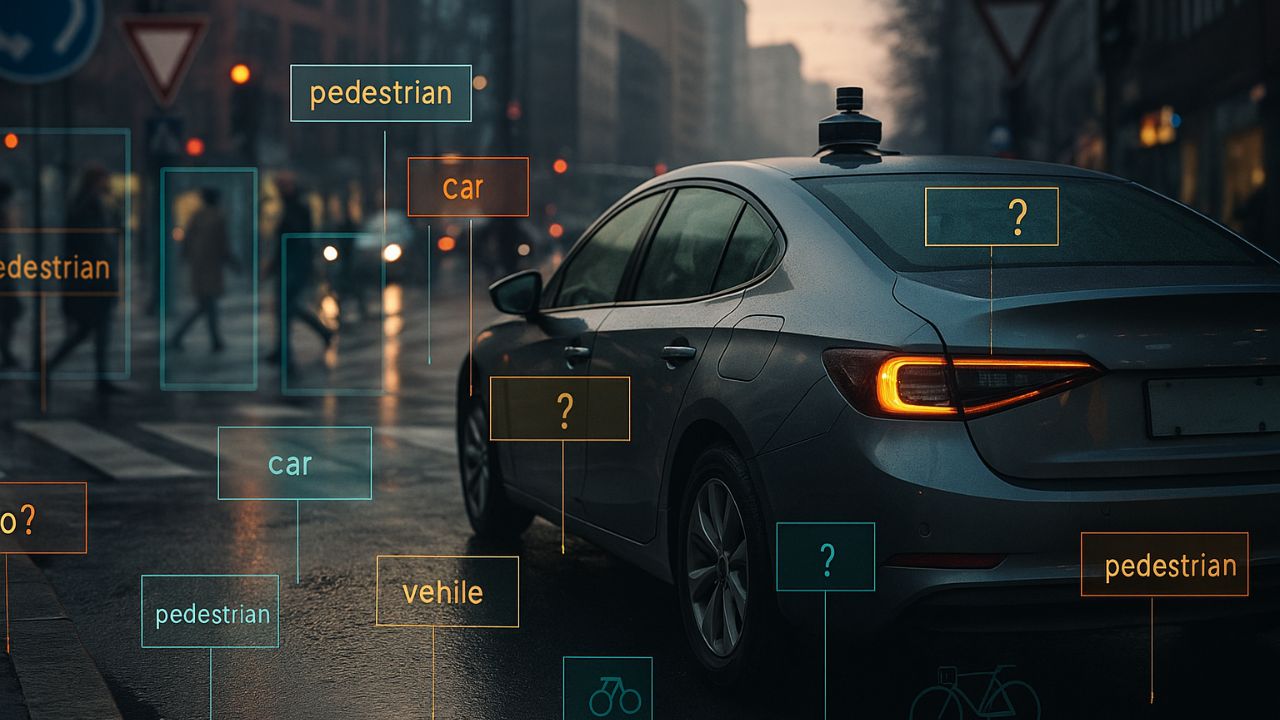

Guida autonoma: un esempio di complessità ambientale

Nel settore della guida autonoma, i sistemi di visione artificiale devono interpretare segnali, ostacoli, condizioni meteo e comportamenti umani in tempo reale. Gli algoritmi spesso falliscono in situazioni impreviste o ambigue, mostrando i limiti nella capacità di generalizzazione e nella gestione del contesto.

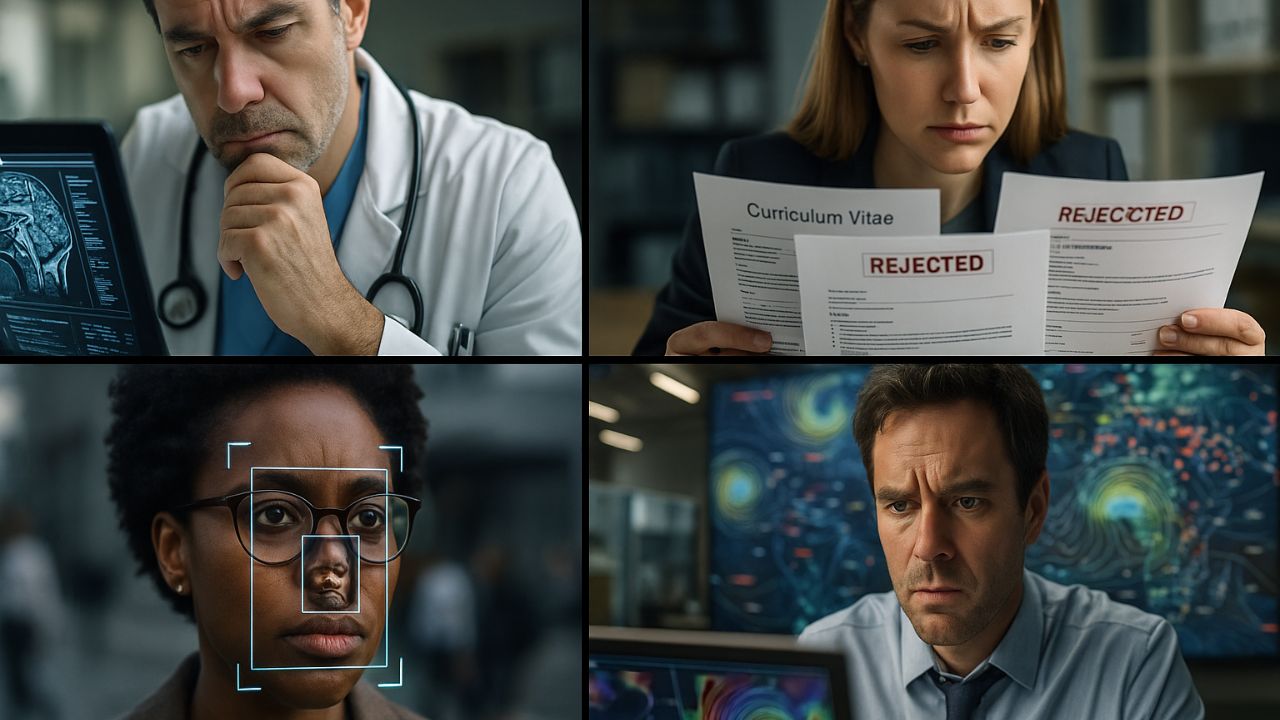

Diagnostica medica: accuratezza vs. interpretabilità

Nel campo della diagnostica, i modelli di machine learning hanno mostrato performance eccezionali nel rilevare malattie da immagini o dati clinici. La difficoltà nel spiegare le decisioni limita il loro utilizzo in ambito clinico, dove medici e pazienti richiedono trasparenza e giustificazioni verificabili.

Riconoscimento facciale e bias algoritmico

Le tecnologie di riconoscimento facciale sono ampiamente usate in ambito sicurezza e sorveglianza. Tuttavia, studi indipendenti hanno evidenziato errori più frequenti su individui non caucasici o su donne, sollevando importanti questioni di bias e discriminazione algoritmica.

Mercato del lavoro e decisioni automatizzate

Alcune aziende utilizzano strumenti di screening automatico dei CV, basati su machine learning, per selezionare i candidati. Se il sistema è stato addestrato su dati sbilanciati, rischia di penalizzare profili validi solo perché atipici, perpetuando dinamiche di esclusione inconsapevoli.

Previsioni climatiche: oltre i limiti computazionali

Le applicazioni nel campo della meteorologia mostrano come l’enorme quantità di dati disponibili possa essere sfruttata dal machine learning per previsioni più precise. Tuttavia, la necessità di modelli computazionalmente intensivi e la difficoltà nell’adattarsi a eventi estremi o senza precedenti rappresentano ancora barriere significative.

Questi casi d’uso reali evidenziano come i limiti del machine learning incidano concretamente su risultati, scelte e responsabilità. È qui che la ricerca e l’innovazione devono concentrarsi per trasformare promesse in soluzioni affidabili.

Oltre i Limiti del Machine Learning

I limiti del machine learning non rappresentano una condanna, ma un invito all’evoluzione: comprenderli è il primo passo per costruire modelli più intelligenti, trasparenti e allineati ai bisogni della società.

Le sfide emerse — dalla mancanza di interpretabilità alla scarsa robustezza, dai bias nei dati all’impatto ambientale — richiedono una risposta che non sia solo tecnologica, ma anche etica e culturale. Non si tratta solo di sviluppare nuovi algoritmi, ma di ripensare l’intero ecosistema dell’intelligenza artificiale.

Le nuove frontiere della ricerca, come il machine learning interpretabile, l’apprendimento federato e i modelli efficienti dal punto di vista energetico, mostrano che è possibile avanzare in una direzione più consapevole e sostenibile.

Ma la vera sfida è multidisciplinare: ingegneri, data scientist, filosofi, giuristi ed educatori devono collaborare per definire i confini e le regole di un’intelligenza artificiale che sia utile, giusta e accessibile a tutti.

Guardare ai limiti del machine learning come occasione di crescita è ciò che può trasformare questa tecnologia in uno strumento realmente al servizio dell’umanità.

Prospettive future e come restare aggiornati

I limiti del machine learning non sono statici: si evolvono insieme al progresso tecnologico, alla disponibilità di dati e alle esigenze sociali. Rimanere aggiornati è essenziale per non rimanere indietro.

L’evoluzione dell’AI spiegabile

L’interesse per l’intelligenza artificiale spiegabile continuerà a crescere nei prossimi anni, spinta dalle normative europee e dall’esigenza di costruire sistemi più trasparenti. Le aziende dovranno integrare strumenti che permettano di comprendere le decisioni degli algoritmi in tempo reale.

Standard etici e regolamentazioni

L’Unione Europea e altri enti internazionali stanno lavorando per definire standard etici e linee guida sull’uso dell’intelligenza artificiale. Sarà cruciale per professionisti e imprese conoscere questi sviluppi e adattare i propri modelli di business alle nuove regole.

Apprendimento continuo e formazione

La rapida evoluzione del settore richiede un costante aggiornamento delle competenze. Dai corsi universitari ai bootcamp online, sono sempre di più le risorse disponibili per chi vuole specializzarsi in ambiti come data science, AI etica e machine learning sostenibile.

Risorse per approfondire

- AI News – La nostra sezione dedicata alle ultime novità sull’Intelligenza Artificiale

- Coursera, edX, Udacity – Piattaforme per corsi professionali aggiornati

- Segui i canali ufficiali di istituzioni come OECD.AI o AI Act EU per aggiornamenti legislativi

Conoscere i limiti del machine learning oggi significa essere pronti per le innovazioni di domani. Informarsi, formarsi e condividere è la chiave per accompagnare l’AI verso un futuro più equo e consapevole.

Come affrontare i limiti del Machine Learning nel lavoro quotidiano

I limiti del machine learning non devono essere un ostacolo insormontabile: possono essere gestiti e ridotti attraverso buone pratiche, consapevolezza tecnica ed etica, e scelte strategiche nella fase di progettazione e sviluppo.

1. Valutare i dati prima del modello

Spesso si sottovaluta il ruolo dei dati. Prima di scegliere un algoritmo, è fondamentale analizzare la qualità, la provenienza e la rappresentatività dei dataset. Evitare bias nascosti e dati rumorosi migliora drasticamente l’affidabilità del modello.

2. Scegliere la semplicità quando possibile

Non sempre il modello più complesso è la scelta migliore. In molti casi, algoritmi più semplici e interpretabili offrono performance comparabili con maggiore trasparenza. Valutare sempre il trade-off tra accuratezza e comprensibilità.

3. Introdurre processi di validazione continua

Una buona pratica è implementare pipeline di validazione e monitoraggio costante delle performance nel tempo. Questo consente di rilevare in anticipo fenomeni come drift dei dati o overfitting progressivo, mantenendo il modello aggiornato rispetto al contesto reale.

4. Collaborare in modo interdisciplinare

L’uso del machine learning non può essere delegato unicamente a ingegneri o data scientist. Coinvolgere figure legali, esperti etici, stakeholder e utenti finali aiuta a costruire sistemi più robusti e utili, anche dal punto di vista sociale e normativo.

5. Educare l’organizzazione

Formare manager e team operativi sull’utilizzo consapevole dell’intelligenza artificiale permette di ridurre errori di implementazione, aspettative irrealistiche o resistenze culturali. L’alfabetizzazione AI è oggi una competenza trasversale chiave.

Incorporare queste strategie nel quotidiano aiuta a gestire concretamente i limiti del machine learning e a trasformarli in elementi di valore, promuovendo un’adozione più consapevole e sostenibile dell’intelligenza artificiale nei processi aziendali e pubblici.